复旦大学: 全球首个多模态奖励模型问世

- 2025-08-05 02:53:01

- 826

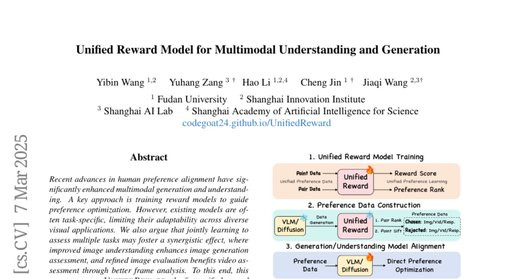

这项由复旦大学王艺斌、张宇航等研究团队与上海人工智能实验室合作完成的突破性研究发表于2025年3月,论文题为《UnifiedRewardModelforMultimodalUnderstandingandGeneration》。有兴趣深入了解的读者可以通过论文网址codegoat24.github.io/UnifiedReward访问完整资料。

在人工智能的世界里,有一个长期存在的问题就像是缺少了统一的"评委"。当我们让AI生成图片或视频时,不同的AI系统就像是不同比赛项目的选手,而每个项目都有自己专门的裁判。比如,判断图片质量的裁判不能评价视频,评价视频的裁判又不懂图片理解。这就好比奥运会上,游泳裁判不能去评判体操,体操裁判又不懂跳水规则。

复旦大学的研究团队意识到这个问题的严重性。在现实应用中,这种各自为政的评价体系造成了巨大的资源浪费和效率低下。每当公司想要开发一个新的AI产品时,他们就必须为图片生成、视频制作、图片理解、视频分析等不同功能分别训练专门的评价模型。这就像是一家餐厅需要雇佣专门品尝中餐的评委、专门品尝西餐的评委、专门评价甜点的评委,每个评委只会做一件事。

更有趣的是,研究团队发现了一个重要的洞察:不同的视觉任务其实是相互关联的,就像一个优秀的美食评委在品尝中餐时积累的经验,同样能帮助他更好地评价西餐。当AI系统学会了如何判断图片质量时,这种能力实际上也能帮助它更好地评价图片生成的效果。同样,当它掌握了图片评价的技巧后,也能更准确地分析视频中的每一帧画面。

基于这种认识,研究团队开发出了世界上第一个统一的多模态奖励模型——UnifiedReward。这个模型就像是培养了一位全能型评委,他不仅能够评判各种不同类型的视觉内容,还能在不同任务之间相互借鉴经验,做出更准确的判断。

UnifiedReward的工作原理可以用培训一位全能型品酒师来比喻。传统的做法是分别培训红酒品鉴师、白酒品鉴师、啤酒品鉴师,每个人只专精一个领域。而UnifiedReward的方法是培训一位全才,让他同时学习品鉴各种酒类。在这个过程中,他在品鉴红酒时积累的对香气、口感、色泽的敏感度,同样能帮助他更好地评价白酒和啤酒。

这个统一模型具备两种核心能力:配对排名和单点评分。配对排名就像是让评委比较两个作品并选出更好的那个,而单点评分则是让评委给单个作品打出具体分数。这种双重能力使得UnifiedReward能够适应各种不同的应用场景。

为了训练这样一个全能型评委,研究团队首先构建了一个大规模的人类偏好数据集,包含了大约23.6万条数据,涵盖了图片生成、图片理解、视频生成、视频理解四个主要领域。这就像是为评委准备了一个包含各种类型作品的训练题库,确保他能见识到足够多样化的样本。

在具体实现上,研究团队采用了一个三步走的策略。第一步是训练统一奖励模型,就像是对评委进行基础培训。第二步是构建高质量的偏好数据,这个过程特别巧妙——他们让训练好的模型来帮助筛选和组织训练数据,就像让经验丰富的老师来挑选教学案例。第三步是使用这些精心筛选的数据来对各种AI模型进行偏好对齐优化。

一、统一评价体系的革命性突破

要理解UnifiedReward的革命性意义,我们需要先了解之前AI评价体系的问题。传统的AI评价就像是古代的行业公会制度,每个行业都有自己的标准和规则,彼此之间壁垒森严。图片生成有自己的评价标准,比如PickScore、ImageReward等模型;视频生成又有另一套评价体系,如VideoScore、VideoReward等;而图片理解和视频理解则各自有专门的评判工具。

这种分割式的评价体系带来了多重问题。首先是资源浪费,每开发一个新的AI应用,就需要重新训练对应的评价模型,就像每开一家新餐厅都要重新培训所有服务员一样低效。其次是标准不统一,不同评价模型的判断标准可能存在冲突,导致AI系统无法获得一致的反馈信号。

更重要的是,这种割裂忽视了视觉任务之间的内在联系。研究团队通过大量实验发现,当AI系统学会了判断图片质量时,这种能力能够显著提升它评价图片生成效果的准确性。同样,掌握了图片评价技能的AI在处理视频任务时也表现得更加出色,因为视频本质上是由连续的图片帧组成的。

UnifiedReward的设计理念就是要打破这些人为的壁垒,创建一个真正统一的评价体系。这个系统不仅能够处理不同类型的视觉任务,更重要的是能够在不同任务之间实现知识的迁移和共享。当系统在图片理解任务上积累经验时,这些经验会自动帮助提升图片生成的评价准确性;而在图片相关任务上的所有学习成果,又会进一步增强视频任务的处理能力。

为了验证这种跨任务协同效应,研究团队进行了详细的对比实验。他们发现,单独训练图片理解评价模型的准确率是46.8%,而同时学习图片理解和图片生成评价的模型准确率提升到53.5%。更令人惊讶的是,当模型同时学习图片和视频理解任务时,准确率进一步提升到55.1%。最终的统一模型在所有任务上都取得了最佳性能,整体准确率达到66.5%。

这种协同效应的机制可以用学习外语来类比。当你学习英语时,掌握的语法规则和词汇积累不仅帮助你更好地理解英语,也为学习法语、德语等其他语言奠定了基础。同样,AI在学习判断图片质量时积累的对色彩、构图、清晰度的理解,同样适用于评价视频的视觉效果。

二、大规模数据集的精心构建

要训练一个全能型评委,首先需要一个包含丰富多样案例的训练题库。研究团队面临的第一个挑战就是如何构建一个涵盖所有视觉任务类型的大规模数据集。这个过程就像是为一所综合性大学收集各个学科的教材和参考资料。

现有的数据集都有明显的局限性。图片生成领域有EvalMuse、HPD等数据集,视频生成有VideoDPO、VideoFeedback等,图片理解有LLaVA-Critic数据,视频理解有ShareGPTVideo数据。但这些数据集都是为特定任务设计的,格式标准、评价维度、数据规模都不统一,就像是用不同语言写成的教科书,无法直接整合使用。

研究团队采用了一种系统性的数据整合策略。他们首先对现有数据集进行深入分析,识别出每个数据集的核心价值和独特贡献。然后设计了统一的数据预处理流程,将不同格式的数据转换为标准化的训练样本。这个过程需要极其细致的工作,就像是将不同出版社的教材重新编排成统一的课程体系。

在图片生成任务上,团队整合了多个重要数据集。EvalMuse提供了4000个提示词,每个提示词对应多张由不同模型生成的图片,并配有详细的人工评分。HumanPreferenceDataset包含70万条人类偏好投票数据,记录了用户对不同生成图片的选择偏好。Open-Image-Preferences则贡献了7400对文本到图片的偏好数据。

处理这些数据时,研究团队采用了巧妙的策略来同时支持配对排名和单点评分两种训练方式。对于配对排名,他们从同一提示词生成的多张图片中选择评分最高和最低的作为对比样本。对于单点评分,他们将多个评估者的分数进行平均,并整合整体评分和元素级别的标注信息,形成综合的评价答案。

视频生成数据的处理面临更大挑战,因为视频评价涉及时间维度上的连贯性和动态效果。VideoDPO提供了1万对合成视频的对比数据,专门用于文本到视频模型的偏好学习。LiFT-HRA和VideoFeedback则提供了大量的人工评分数据,每个视频都有详细的多维度评价分数和评价理由。

在理解任务方面,团队使用了LLaVA-Critic的数据集,其中包含4万条单点评分数据和7.3万条配对排名数据。这些数据专门针对图片理解任务的评价学习,涵盖了多种评价标准和场景。视频理解则主要依托ShareGPTVideo-DPO数据集,包含1.7万条视频理解的DPO数据。

数据预处理过程中,团队特别注意保持评价标准的一致性。对于配对排名数据,他们统一采用"X比Y更好"的表达格式。对于包含评价理由的数据,他们保留了人类的推理过程,让模型能够学习到评价的逻辑和依据。而对于单点评分,他们没有强制统一评分范围,而是让模型学习适应不同数据集的评分体系和标准。

最终构建的统一数据集包含约23.6万条训练样本,均匀覆盖了四个主要任务类型。这个数据集的价值不仅在于规模庞大,更在于其内在的多样性和互补性。不同任务的数据能够相互补充,帮助模型建立更全面的视觉评价能力。

三、创新性的三阶段训练策略

有了丰富的训练数据,如何有效地训练出一个全能型评价模型成为了关键问题。研究团队设计了一个创新的三阶段训练策略,这个过程就像是培养一位世界级的全能运动员。

第一阶段是统一奖励模型的训练。研究团队选择了LLaVA-OneVision7B作为基础模型,这是一个在图片和视频理解方面都表现出色的预训练模型。选择这个模型作为起点就像是选择一个已经具备良好身体素质的运动员作为培养对象。

训练过程采用了多任务联合学习的策略。模型需要同时学习处理四种不同类型的任务:图片生成评价、视频生成评价、图片理解评价、视频理解评价。对于生成任务的评价,模型的输入包括视觉内容、指令和文本描述;对于理解任务的评价,模型的输入则包括视觉内容、问题和对应的回答。

训练的目标是让模型能够根据指令要求,输出相应的评价结果。这可能是一个具体的评分,也可能是两个选项之间的排名选择。如果训练数据中包含了评价的理由和解释,模型还需要学习生成详细的评价说明。

第二阶段是偏好数据的自动构建。这是整个训练策略中最具创新性的部分。传统的方法通常是先收集人工标注的偏好数据,然后直接用于模型训练。而这里的方法是让训练好的统一奖励模型来帮助构建更高质量的偏好数据。

这个过程包含三个精密设计的步骤。首先是数据生成,让目标AI模型(比如图片生成模型或视频理解模型)针对给定的输入生成多个候选输出。这就像是让多个选手参加同一项比赛,产生可供比较的作品。

接下来是配对排名阶段。统一奖励模型会对这些候选输出进行两两比较,识别出相对较好和相对较差的输出。这个过程会产生一个"优选列表"和一个"劣选列表"。这种方法的优势在于能够捕捉到输出之间的相对质量差异。

最后是单点筛选阶段。奖励模型会对优选列表和劣选列表中的所有输出进行绝对质量评分,然后从优选列表中选择得分最高的输出作为最终的正例,从劣选列表中选择得分最低的输出作为最终的负例。这种双重筛选机制确保了偏好数据的高质量。

通过这种方法构建的偏好数据具有很高的可靠性。配对排名捕捉了相对质量差异,单点筛选确保了绝对质量水平,两者结合产生了既有区分度又有代表性的训练样本。

第三阶段是模型的偏好对齐优化。利用第二阶段构建的高质量偏好数据,研究团队采用直接偏好优化(DPO)技术来改进目标AI模型的表现。这个过程分别针对生成任务和理解任务采用了不同的优化策略。

对于图片和视频生成任务,优化过程直接作用于扩散模型的去噪预测过程。通过比较微调模型和参考模型在处理偏好样本和非偏好样本时的噪声预测差异,逐步调整模型参数,使其更倾向于生成高质量的输出。

对于理解任务,优化过程则是调整模型的响应概率分布。通过增加对偏好响应的生成概率,同时降低对非偏好响应的生成概率,让模型的输出更符合人类的期望和标准。

整个三阶段策略的巧妙之处在于形成了一个良性循环。第一阶段训练出的统一奖励模型为第二阶段提供了高质量的数据筛选能力;第二阶段构建的精确偏好数据为第三阶段的模型优化提供了可靠的训练信号;而第三阶段优化后的模型又可以为新一轮的训练提供更好的起点。

四、跨任务协同效应的深度分析

UnifiedReward最令人着迷的特性是其跨任务协同效应。为了深入理解这种现象,研究团队进行了大量的对比实验,就像是科学家研究不同化学元素之间的相互作用。

研究团队设计了一系列对照实验来验证跨任务学习的效果。他们分别训练了只专注单一任务的模型和同时学习多个任务的模型,然后比较它们在各自任务上的表现。结果显示了令人惊讶的协同效应。

在图片理解任务上,单独训练的模型在VLRewardBench基准测试中的总体准确率为46.8%。当模型同时学习图片理解和图片生成评价时,准确率显著提升到53.5%。这种提升可以用厨师的经验来理解:一个既懂得品鉴美食又了解烹饪过程的厨师,比只会品尝或只会做菜的人更能准确评价一道菜的优劣。

更有趣的是,当模型进一步学习视频相关任务时,图片理解的性能还会继续提升。同时学习图片和视频理解的模型在图片理解任务上达到了55.1%的准确率。这说明视频理解能力的获得反过来也增强了图片分析能力,因为视频理解需要对时间序列上的图片帧进行连贯分析,这种能力自然地增强了对单个图片的理解深度。

在视频理解任务上,协同效应同样显著。基础模型的准确率为48.2%,单独学习视频理解后提升到74.2%,而同时学习视频和图片理解后进一步提升到76.6%,最终的统一模型达到了84.0%的准确率。这种阶梯式的性能提升清楚地显示了不同任务之间的相互促进作用。

生成任务的评价能力也展现出类似的协同效应。在图片生成评价方面,GenAI-Bench基准测试显示,单独训练的模型准确率为64.0%,而统一模型达到了70.9%。视频生成评价的提升更加明显,从单任务的69.4%提升到统一模型的77.2%。

这种协同效应的机制可以从多个角度来理解。首先是特征表示的共享。不同视觉任务虽然目标不同,但都需要对图像的基本特征进行理解,如颜色、纹理、形状、构图等。当模型在一个任务上学习这些特征表示时,这些知识能够直接迁移到其他任务上。

其次是评价标准的互补。图片生成的评价需要考虑内容的准确性、视觉质量、艺术美感等多个维度。而图片理解的评价则更注重语义的准确性、逻辑的一致性、信息的完整性。这两套评价标准实际上是互补的,综合掌握后能够形成更全面的评价能力。

时间维度的理解也是重要的协同因素。视频任务要求模型理解时间序列上的连贯性和一致性,这种能力的获得让模型对静态图像的理解也更加深入。反过来,对静态图像的深度理解为分析视频中的每一帧提供了坚实基础。

研究团队还发现了一个有趣的现象:即使在训练数据相对较少的任务上,协同学习也能带来显著改善。比如视频生成评价的训练数据相对稀少,但通过与其他任务的联合学习,模型在这个任务上的表现仍然超越了专门的单任务模型。这说明跨任务学习不仅能够提升整体性能,还能够缓解数据稀缺的问题。

这种协同效应的发现对AI系统的设计具有重要启示。传统的做法是为每个任务训练专门的模型,但这项研究证明了统一建模的优势。通过让模型同时学习相关的多个任务,不仅能够提升单项任务的性能,还能够显著提高整体的资源利用效率。

五、实际应用中的显著改进效果

为了验证UnifiedReward在实际应用中的效果,研究团队在多个AI系统上进行了全面的测试和比较。这些测试就像是让新培训的全能教练指导不同类型的运动员,看看他们的成绩能够提升多少。

在图片理解任务上,团队选择了LLaVA-OneVision7B作为基础模型,使用UnifiedReward构建的偏好数据进行优化。测试涵盖了五个不同的基准数据集:LLaVABench、WildVision、LLaVABench-Wilder、LiveBench和MMHal。这些测试就像是对学生进行多科目的综合考试。

结果显示,使用UnifiedReward优化后的模型在所有测试中都取得了显著改进。在LLaVABench测试中,基础模型得分为90.3,经过LLaVA-Critic方法优化后提升到100.3,而使用UnifiedReward优化后达到了101.4。在WildVision测试中,改进更加明显,从基础的54.9提升到67.8。在最具挑战性的LLaVABench-Wilder测试中,UnifiedReward的优化效果最为突出,将得分从67.8提升到75.0。

视频理解任务的改进同样令人印象深刻。研究团队在LLaVA-Video-7B模型上进行了测试,涵盖了六个不同的视频理解基准:MSRVTT、MSVD、TGIF、LongVideoBench、MLVU和Video-MME。在MSRVTT测试中,基础模型的准确率为52.8%,使用现有的Houd-DPO方法可以提升到56.8%,而UnifiedReward将准确率大幅提升到65.0%。在MSVD测试中,改进幅度同样显著,从基础的69.7%提升到78.3%。

生成任务的改进效果更加直观。在图片生成方面,研究团队使用SDXL-Turbo作为基础生成模型,通过三种不同的评价指标进行测试:PickScore、HPSv2和ImageReward。结果显示,基础模型在PickScore指标上的得分为43.24,使用传统的Pick-a-Pic数据集优化后提升到54.32,而使用UnifiedReward构建的偏好数据优化后达到了63.32。在其他两个指标上也有类似的改进幅度。

视频生成的改进效果同样显著。使用T2V-Turbo作为基础模型,在VBench综合评价基准上进行测试。基础模型的总体得分为80.95%,使用传统的VideoDPO方法可以提升到81.80%,而UnifiedReward的优化方法将得分提升到82.10%。在质量维度上,改进从82.71%提升到84.11%,在语义一致性方面从73.93%提升到74.06%。

这些数值背后反映的是实际使用体验的显著改善。在图片生成中,优化后的模型能够更好地理解用户的意图,生成更符合描述的图像,减少无关元素的出现,提高整体的视觉质量。在视频生成中,改进主要体现在时间一致性、动作流畅性和内容准确性方面。

研究团队还进行了定性分析,通过人工评估来验证数值改进的实际意义。他们邀请评估者对比基础模型和优化后模型的输出,结果显示用户确实能够感受到明显的质量提升。在图片生成任务中,优化后的模型生成的图像在细节丰富度、色彩准确性、构图合理性方面都有明显改善。在视频生成中,动作的连贯性、场景的一致性、整体的观感都得到了提升。

特别值得注意的是,UnifiedReward的改进效果在不同类型的任务中表现出了一致性。无论是理解任务还是生成任务,无论是图片还是视频,都能获得稳定的性能提升。这种一致性证明了统一建模方法的可靠性和通用性。

更重要的是,这种改进是在保持模型效率的前提下实现的。UnifiedReward不需要为每个任务训练专门的评价模型,大大减少了计算资源的需求和维护的复杂性。这对于实际部署具有重要意义,特别是对于需要处理多种视觉任务的综合性AI系统。

六、技术创新点与方法论贡献

UnifiedReward的技术创新可以从多个维度来理解,每个创新点都代表了对传统方法的重要突破。这些创新就像是在传统的单项竞技中引入了全能运动的概念,彻底改变了比赛规则。

首先是统一建模架构的创新。传统的做法是为每个视觉任务设计专门的评价模型,这种方法的问题在于无法充分利用任务间的相关性。UnifiedReward采用了单一模型处理多种任务的架构,通过任务特定的输入格式和指令来区分不同的评价需求。这种设计既保持了任务的特异性,又实现了知识的共享。

模型的输入设计特别巧妙。对于生成任务的评价,模型接收视觉内容、指令文本和生成描述作为输入;对于理解任务的评价,模型接收视觉内容、问题文本和回答内容。通过这种统一而灵活的输入格式,单一模型能够适应不同任务的需求,同时保持内部表示的一致性。

双模式评价能力是另一个重要创新。UnifiedReward既能进行配对排名(比较两个输出的优劣),也能进行单点评分(给单个输出打分)。传统方法通常只支持其中一种模式,这限制了模型的应用场景。双模式能力让UnifiedReward能够适应不同的使用需求和评价标准。

数据构建策略的创新性体现在主动学习的应用上。传统方法依赖预先标注的偏好数据,而UnifiedReward采用了"自举"的方法——让训练好的奖励模型来帮助构建更高质量的偏好数据。这种方法的优势在于能够充分利用模型已有的评价能力,生成更加精确和一致的训练样本。

三步骤的数据筛选流程设计得非常精密。首先生成多个候选输出,然后进行配对排名筛选出相对的优劣组,最后通过单点评分在每组中选择极端样本。这种多层筛选确保了最终偏好数据的高质量和强区分度。

跨任务知识迁移机制的发现和利用是最重要的方法论贡献。研究团队不仅验证了这种迁移的存在,还深入分析了其机制和规律。他们发现图片和视频任务之间、理解和生成任务之间都存在显著的正向迁移效应,这为未来的多任务学习研究提供了重要指导。

联合训练策略的优化也值得关注。研究团队没有简单地混合不同任务的数据,而是设计了平衡的采样策略,确保每个任务都能获得充分的学习机会。同时,他们采用了任务特定的损失函数和优化参数,在保持统一性的同时兼顾了任务的特殊性。

评价指令的标准化是另一个重要贡献。研究团队设计了一套统一而灵活的指令模板,能够清晰地向模型传达不同的评价需求。这些指令不仅包含任务类型信息,还包含具体的评价标准和输出格式要求,确保模型能够产生一致和准确的评价结果。

模型优化方面,研究团队针对生成任务和理解任务的不同特点,分别采用了适配的DPO实现。对于生成任务,优化直接作用于扩散过程的噪声预测;对于理解任务,优化调整的是响应概率分布。这种差异化的优化策略体现了对不同任务本质的深入理解。

实验设计的系统性也是重要贡献。研究团队不仅进行了全面的性能对比,还通过消融实验详细分析了每个组件的贡献。他们系统地研究了不同任务组合对性能的影响,为多任务学习的实践提供了具体指导。

这些技术创新的综合效果不仅体现在性能指标的提升上,更重要的是为AI评价系统的发展开辟了新的方向。UnifiedReward证明了统一建模的可行性和优越性,这对于构建更加高效和通用的AI系统具有重要意义。

七、实验验证的全面性与可信度

为了确保研究结果的可靠性和说服力,研究团队设计了极其全面的实验验证体系。这套验证体系就像是对一位全能运动员进行的奥运级别的全面测试,确保在各种不同条件下都能保持优异表现。

实验设计的第一个特点是基准测试的多样性。研究团队没有仅仅依赖单一的评价指标,而是在每个任务类型上都选择了多个权威的基准测试。在图片理解方面,他们使用了VLRewardBench这个专门设计的综合性基准,该基准包含了1250个高质量样本,涵盖了通用多模态查询、视觉幻觉检测和复杂推理任务三个维度。

视频理解的测试更加全面,包括了六个不同特点的数据集:MSRVTT和MSVD主要测试基础的视频描述和问答能力,TGIF专注于动态GIF的理解,LongVideoBench测试长视频的理解能力,MLVU评估多任务长视频理解,Video-MME则是最新的视频多模态评价基准。这种多维度的测试确保了结果的全面性。

在生成任务的评价上,研究团队同样采用了多元化的评价策略。图片生成使用了三个不同的自动评价指标:PickScore注重用户偏好的预测,HPSv2关注人类偏好得分,ImageReward则专门评估文本到图片生成的质量。视频生成则使用了VBench这个综合性评价框架,它从多个维度对视频质量进行全面评估。

对比基线的选择体现了实验的严谨性。研究团队没有仅仅与简单的基线进行比较,而是选择了每个领域内最先进的方法作为对比对象。在图片理解方面,他们与LLaVA-Critic这个专门的图片理解评价模型进行比较,还包括了Gemini-1.5-Pro和GPT-4o这样的顶级商业模型。在视频理解方面,对比对象包括了Houd-DPO和TPO等最新的优化方法。

实验的控制变量设计特别值得关注。为了确保比较的公平性,研究团队在使用不同方法时保持了相同的基础模型、训练数据来源、训练超参数和评价标准。这种严格的控制确保了性能差异确实来源于方法本身,而非其他外在因素。

消融实验的设计揭示了不同组件的具体贡献。研究团队系统地测试了不同任务组合对最终性能的影响。他们分别训练了只包含单一任务、两个任务、三个任务和全部四个任务的模型,清晰地展示了任务数量增加如何逐步提升整体性能。这种阶梯式的实验设计让读者能够直观地理解跨任务学习的价值。

统计显著性的验证增强了结果的可信度。研究团队不仅报告了平均性能数据,还通过多次独立实验验证了结果的稳定性。在一些关键实验中,他们重复进行了多次测试,确保观察到的改进不是偶然现象。

定性分析补充了定量结果的不足。研究团队展示了大量的输出示例,让读者能够直观地看到优化前后的差异。在图片生成中,优化后的模型生成了更加细致和准确的图像;在视频生成中,动作的流畅性和场景的一致性都有明显改善。这些直观的对比为数值结果提供了有力的支撑。

实验结果的一致性也值得注意。无论是在不同的任务类型上,还是在不同的基准测试中,UnifiedReward都表现出了一致的优势。这种一致性表明方法的改进不是针对特定场景的过度优化,而是真正的通用性提升。

错误分析和失败案例的讨论增加了研究的完整性。研究团队诚实地报告了方法的局限性,分析了在某些特定情况下性能改进有限的原因。这种客观的态度提高了研究的可信度。

实验规模的充分性也需要强调。研究团队使用了大规模的测试数据,确保统计结果的可靠性。在一些关键测试中,样本数量达到了数千甚至上万,这样的规模足以支撑得出的结论。

重现性考虑体现了负责任的研究态度。研究团队详细描述了实验设置、超参数选择、数据预处理方法等关键细节,并承诺开源相关代码和数据,让其他研究者能够验证和扩展这项工作。

说到底,这项研究在人工智能领域真正实现了一个重要突破。过去,我们需要为每种不同的视觉任务训练专门的评价模型,就像需要为每种运动项目配备专门的裁判。现在,研究团队创造了一个"全能裁判",不仅能够胜任各种不同的评判工作,而且通过跨领域的经验积累,在每个单项上的表现都超过了专业的单项裁判。

这种统一建模的成功不仅仅是技术上的进步,更代表了AI系统设计思路的根本转变。从专门化走向通用化,从孤立学习走向协同学习,这种转变将为未来的AI应用带来更高的效率和更好的性能。

研究团队构建的23.6万条训练数据涵盖了图片生成、图片理解、视频生成、视频理解四个核心领域,这个数据集本身就是对学术界的重要贡献。更重要的是,他们提出的三阶段训练策略——统一奖励模型训练、偏好数据构建、模型对齐优化——为其他研究者提供了清晰的技术路线图。

实验结果的显著性令人印象深刻。在图片理解任务上,统一模型的准确率比单任务模型提升了19.7个百分点;在视频理解上提升了35.8个百分点。这样的改进幅度在AI研究中是相当罕见的,说明了跨任务协同学习的巨大潜力。

从实际应用的角度来看,这项技术将大大降低AI系统开发和维护的成本。公司不再需要为每种视觉任务单独训练评价模型,而是可以使用一个统一的系统来处理所有需求。这种效率提升对于AI技术的普及和商业化具有重要意义。

当然,这项研究也存在一些局限性。目前的数据分布在不同任务间仍有不平衡,训练数据的质量和数量还有进一步提升的空间。研究团队也坦诚地指出,使用更大规模的模型(如72B参数)可能会带来更好的效果,而在线优化方法可能比当前的离线方法更加有效。

展望未来,这项研究为多模态AI系统的发展指明了方向。随着数据规模的不断扩大和模型能力的持续提升,我们有理由相信,这种统一建模的思路将在更多AI任务中得到应用,最终实现真正通用的人工智能系统。

对于普通用户而言,这项技术的成果将体现在日常使用的AI产品中。未来的图片生成工具将更好地理解用户意图,视频制作软件将产生更加流畅自然的内容,而各种视觉AI应用的整体质量都将得到显著提升。这正是科技进步的真正价值所在——让技术更好地服务于人类的创造性工作和日常生活。

Q&A

Q1:UnifiedReward到底是什么?它和传统的AI评价方法有什么不同?A:UnifiedReward是全球首个统一的多模态奖励模型,就像培养了一位全能型评委,能够同时评判图片生成、视频生成、图片理解、视频理解四种不同任务。传统方法需要为每种任务训练专门的评价模型,而UnifiedReward用一个模型就能处理所有任务,而且通过跨任务学习,在每个单项上的表现都超过了专门的单任务模型。

Q2:这种跨任务协同学习真的有效吗?具体提升有多大?A:非常有效。实验显示,同时学习多个任务比单独学习一个任务的效果要好得多。比如在图片理解任务上,单任务模型准确率是46.8%,而统一模型达到了66.5%,提升了近20个百分点。这就像一个既会品尝又懂烹饪的厨师,比只会其中一样的人更能准确评价食物质量。

Q3:普通用户什么时候能用上这种技术?会对日常使用产生什么影响?A:这项技术主要是面向AI系统开发者的底层技术,普通用户不会直接使用,但会间接受益。未来使用AI生成图片和视频的工具时,生成质量会更高,更符合用户期望;AI对图片和视频的理解也会更准确。简单说,就是各种视觉AI产品的整体表现都会变得更好。

- 上一篇:山姆客服称坚果有蠕虫不是个例

- 下一篇:女孩漂流遭男子高压水枪攻击致失明