AI推理也能″画草图″? KAIST团队让大模型思考更高效

- 2025-08-01 05:17:37

- 894

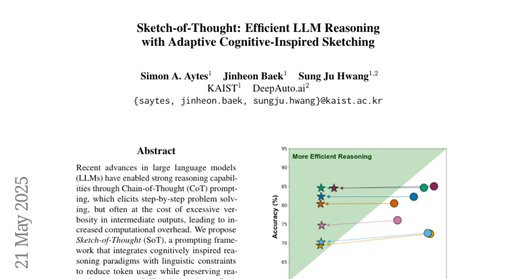

这项由韩国KAIST的SimonA.Aytes、JinheonBaek和SungJuHwang,以及DeepAuto.ai的研究团队共同完成的研究发表于2025年5月,题为《Sketch-of-Thought:EfficientLLMReasoningwithAdaptiveCognitive-InspiredSketching》。有兴趣深入了解的读者可以通过arXiv:2503.05179v2访问完整论文。

当我们遇到复杂问题时,大脑往往不会一开始就在脑海中写出完整的句子,而是先勾勒出思维的轮廓。数学家会用简洁的符号表示复杂的概念,医生会用专业术语快速交流病情,建筑师会画出草图而不是详细描述。这种"思维草图"让专家们能够高效地处理复杂信息。

研究团队发现,当前大型语言模型的推理方式就像一个话痨的学生,即使是简单的数学题也要写出冗长的解题过程。比如计算"火车以每小时60英里的速度行驶3小时能走多远"这样的问题,传统的链式思维方法会产生大段文字说明,而实际上用"距离=速度×时间=60×3=180英里"这样的简洁表达就足够了。这种冗余不仅浪费计算资源,还增加了成本。

研究团队开发出一套名为"思维草图"(Sketch-of-Thought,简称SoT)的新方法,让AI能够像人类专家一样用简洁、结构化的方式进行推理。这套方法不需要重新训练模型,只需要改变与AI对话的方式,就能让输出内容减少多达78%,同时保持甚至提升准确性。

**一、三种认知启发的推理方式**

研究团队基于认知科学原理,设计了三种不同的"思维草图"方式,就像为不同类型的问题配备了专门的工具。

第一种叫做"概念链接",灵感来自人类的联想记忆。当你听到"首尔"这个词时,大脑会自动联想到"韩国",进而想到"韩元"。这种方法用箭头连接关键概念,形成推理链条。比如回答"首尔使用什么货币"时,AI会简洁地表达为"首尔→韩国→韩元",而不是写出"首尔是韩国的首都,韩国的官方货币是韩元"这样的完整句子。这种方法特别适合常识推理、多步推理和逻辑推理任务。

第二种叫做"分块符号化",基于工作记忆的组块理论。认知科学研究表明,人类一次只能在工作记忆中保持5到9个信息单位,但我们可以通过"分块"来处理更复杂的信息,就像记忆电话号码时我们会分成区号、前缀和后四位数字。这种方法将数学推理转换为紧凑的符号表达。比如计算汽车加速度问题时,AI会直接写"a=2.5m/s?,t=10s,vi=15m/s,vf=15+(2.5×10),vf=40m/s",而不是用自然语言详细解释每一步。

第三种叫做"专家词汇",模仿领域专家使用的专业简写。就像医生说"STEMI"而不是"ST段抬高型心肌梗死",工程师用"μm"而不是"微米"一样,这种方法使用领域特定的缩写和符号来压缩推理过程。当处理医学问题时,AI会使用"STEMI→ST段抬高心梗,MONA→吗啡、氧气、硝酸酯类、阿司匹林"这样的专业表达,而不是写出完整的医学术语解释。

**二、智能路由系统的自动选择**

面对成千上万的不同问题,如何为每个问题选择最合适的推理方式呢?研究团队开发了一个轻量级的"路由器",就像一个经验丰富的图书管理员,能够快速判断每本书应该放在哪个书架上。

这个路由器基于DistilBERT模型构建,经过14200个样本的训练学习。当收到一个新问题时,它会分析问题的语言特征和结构模式,然后自动选择最适合的推理方式。比如,当遇到包含数字、公式或计算的问题时,它会选择"分块符号化"方式。当问题涉及概念之间的关系推理时,它会选择"概念链接"方式。当问题充满专业术语和领域知识时,它会选择"专家词汇"方式。

实验结果显示,这个路由器的准确率达到96.4%,能够在绝大多数情况下做出正确的选择。更重要的是,它的运行开销非常小,不会显著增加计算成本。

**三、广泛实验验证效果显著**

为了验证"思维草图"方法的有效性,研究团队进行了大规模的实验测试,就像一次全面的体检,从多个角度检验这个方法的健康状况。

他们在15个不同类型的推理数据集上进行测试,涵盖数学推理、常识推理、逻辑推理、多步推理、科学推理和医学推理等六大类别。这些数据集包括GSM8K(小学数学应用题)、CommonsenseQA(常识问答)、LogiQA(逻辑推理)、HotPotQA(多步推理)、QASC(科学推理)和PubMedQA(医学推理)等知名数据集。

测试涵盖了7种不同的大型语言模型,包括开源模型Qwen-2.5系列(7B、14B、32B参数版本)、LLaMA-3.1-8B和LLaMA-3.2-11B,以及闭源模型GPT-4o和ClaudeSonnet3.5。这样的测试范围确保了结果的普遍适用性。

实验结果令人印象深刻。在保持推理准确性的同时,"思维草图"方法平均减少了73%的输出token数量。在某些模型上,这个数字甚至达到78%。更令人惊喜的是,在数学推理和多步推理任务中,这种方法不仅减少了输出长度,还提高了准确性。

具体来看,在Qwen-2.5-32B模型上,"思维草图"达到了82.30%的准确率,略高于传统链式思维的82.24%,同时将输出长度减少了74.36%。在GPT-4o上,准确率为84.55%,仅比传统方法低0.09%,但输出长度减少了76.2%。这种效果在不同规模的模型上都得到了验证。

**四、多语言和多模态的适应能力**

研究团队还测试了"思维草图"方法在不同语言和输入模态下的表现,就像检验一个翻译工具是否能在不同语言间自如切换。

在多语言测试中,他们选择了韩语、意大利语和德语进行实验。结果显示,这种方法在所有三种语言上都实现了超过85%的token减少。虽然在韩语和意大利语上准确率略有下降(分别为1.01%和2.00%),但在德语上反而提高了1.50%。这表明"思维草图"的核心原理能够跨越语言界限,在不同的语言结构中保持有效性。

在多模态测试中,研究团队使用包含图像的ScienceQA和GQA数据集进行实验。结果显示,即使在处理视觉信息时,这种方法仍然能够有效减少文本输出长度。在ScienceQA上,输出长度减少80.95%,准确率仅下降1.00%。在GQA上,准确率下降4.00%,但仍实现了77.2%的token减少。这种在视觉推理任务上的表现证明了方法的通用性。

**五、与现有方法的深入比较**

为了更全面地评估"思维草图"的价值,研究团队将其与其他压缩推理方法进行了详细比较,就像在超市里比较不同品牌产品的性价比。

他们比较了三种基线方法:传统的链式思维(CoT)、受限链式思维(CCoT)和草稿链式思维(CoD)。受限链式思维通过限制总字数(45个单词)来减少输出长度,草稿链式思维则限制每个推理步骤的长度(5个单词以内)。

比较结果显示,虽然草稿链式思维能够实现最激进的长度压缩(平均减少75.83%),但准确率下降了4.68%。受限链式思维的表现更为平衡,但准确率仍下降了4.66%,token减少率为67.87%。相比之下,"思维草图"方法在实现73.49%token减少的同时,准确率仅下降1.07%,显示出更好的精度-效率平衡。

更重要的是,"思维草图"方法还能与其他高级推理策略结合使用。研究团队测试了与自一致性(Self-Consistency)、自精化(Self-Refine)和多智能体辩论(Multi-AgentDebate)的结合效果。结果显示,在所有三种场景中,"思维草图"都能在提升性能的同时大幅减少token使用量。比如在自精化场景中,性能提升0.27%的同时token减少60.3%。

**六、深入的路由分析和案例研究**

研究团队对路由器的工作机制进行了深入分析,就像解剖一个精密仪器来理解其工作原理。

分析显示,路由器的选择与任务类型高度吻合。在数学推理任务(如GSM8K、SVAMP、AQUA-RAT)中,几乎所有样本都被路由到"分块符号化"方式。在常识推理和多步推理任务中,绝大多数样本被路由到"概念链接"方式。在医学推理任务(如PubMedQA、MedQA)中,大部分样本被路由到"专家词汇"方式。这种高度的对应关系证明了路由器能够准确识别不同类型问题的特征。

通过具体案例分析,可以更清楚地看到不同方式的效果。比如对于数学问题"达雷尔和艾伦的年龄比是7:11,如果他们现在的总年龄是162岁,请计算艾伦10年后的年龄","分块符号化"方式会产生类似"设年龄为7x和11x,7x+11x=162,x=9,艾伦现在99岁,10年后109岁"的简洁表达。

对于常识问题"北极熊需要什么环境","概念链接"方式会表达为"北极熊→北极→寒冷环境"。对于医学问题"钬激光是输尿管最佳的体内碎石器吗","专家词汇"方式会使用"Ho:YAG激光→体内碎石→输尿管→最佳选择"这样的专业表达。

**七、实际应用价值和影响**

"思维草图"方法的价值不仅体现在实验数据上,更在于其实际应用的广阔前景。在当前AI服务成本日益成为关注焦点的背景下,这种方法提供了一个既保持质量又降低成本的解决方案。

对于企业用户来说,token使用量的大幅减少直接转化为成本节约。以GPT-4o为例,如果原本需要1000个token来完成一个推理任务,使用"思维草图"方法后只需要约240个token,成本降低了76%。对于大规模应用的企业来说,这种节约是非常可观的。

对于模型服务提供商来说,输出长度的减少意味着计算资源的节约和服务效率的提升。同样的硬件资源可以服务更多的用户请求,或者为相同数量的用户提供更快的响应速度。

更重要的是,这种方法不需要重新训练模型,只需要改变提示词设计,这大大降低了部署门槛。任何使用大型语言模型的应用都可以相对容易地集成这种方法,无需额外的技术投入或硬件升级。

研究还显示,"思维草图"方法与现有的高级推理策略兼容性良好。这意味着已经在使用复杂推理流程的应用可以无缝集成这种优化,获得额外的效率提升而不需要重新设计整个系统。

**八、局限性和未来发展方向**

尽管"思维草图"方法取得了显著成果,研究团队也诚实地指出了当前的局限性和未来的改进方向。

目前的方法使用固定的示例来指导模型行为,这可能限制了对任务内细微变化的适应性。未来的研究可能会探索检索增强的示例策略,根据具体问题动态选择最相关的示例,从而提高方法的灵活性和适应性。

另一个需要考虑的问题是,"思维草图"方法通过压缩中间推理步骤来提高效率,但在某些高风险应用场景中,完整的推理过程可能是必需的。比如在医疗诊断或法律分析中,详细的推理步骤有助于人类专家理解和验证AI的决策过程。因此,在这些领域应用时需要谨慎考虑可解释性和透明度的要求。

研究团队还指出,当前的三种推理范式虽然覆盖了大多数常见的推理类型,但随着AI应用场景的不断扩展,可能需要开发更多专门针对特定领域或任务类型的推理范式。这为未来的研究提供了广阔的探索空间。

此外,路由器模型虽然表现良好,但其训练数据来自GPT-4o的标注,可能继承了该模型的某些偏见。未来的研究可能需要探索更多样化和客观的标注方法,以提高路由决策的公平性和准确性。

说到底,这项研究为大型语言模型的高效推理提供了一个全新的思路。通过模仿人类专家的思维方式,"思维草图"方法成功地在保持推理质量的同时大幅提高了效率。这不仅是技术上的突破,更是对AI推理机制的深层理解和优化。

随着AI技术的快速发展和广泛应用,效率和成本问题变得越来越重要。这项研究提供的解决方案不仅解决了当前的实际问题,也为未来AI系统的设计提供了重要启示。通过认知科学指导的设计理念,我们可以让AI系统更好地模仿人类思维的优势,实现真正的智能化。

对于普通用户来说,这意味着未来与AI交互时可能会获得更快的响应速度和更低的使用成本。对于开发者和研究者来说,这项研究展示了跨学科合作的价值,认知科学的洞察如何指导AI技术的改进。对于整个AI行业来说,这种效率导向的研究方向可能会推动更多创新,让AI技术变得更加实用和普及。

有兴趣深入了解技术细节的读者可以查阅完整论文,其中包含了详细的实验设计、数据分析和技术实现细节。这项研究不仅在学术上具有重要价值,更为AI技术的实际应用提供了切实可行的改进方案。

Q&A

Q1:思维草图方法是什么?它是如何工作的?A:思维草图是一种让AI用简洁方式进行推理的方法,模仿人类专家的思维模式。它包含三种方式:概念链接(用箭头连接关键概念)、分块符号化(用数学符号表达)、专家词汇(使用专业简写)。系统会自动选择最适合的方式来处理不同类型的问题。

Q2:这种方法会不会影响AI回答的准确性?A:不会,反而在某些情况下还能提高准确性。实验显示,在大幅减少输出长度(平均73%)的同时,准确率变化很小(平均仅下降1.07%)。在数学和多步推理任务中,准确率甚至有所提升。

Q3:普通用户能使用这种技术吗?有什么好处?A:目前这是一项研究技术,需要AI服务提供商集成到他们的系统中。一旦普及,用户将享受到更快的响应速度、更低的使用成本,同时获得同样准确的回答。这种方法不需要重新训练模型,部署相对容易。